在安装gcc编译器的时候报错:

glibc-headers-2.5-123.el5_11.1.x86_64 from updates has depsolving problems

–> Missing Dependency: kernel-headers is needed by package glibc-headers-2.5-123.el5_11.1.x86_64 (updates)

glibc-headers-2.5-123.el5_11.1.x86_64 from updates has depsolving problems

–> Missing Dependency: kernel-headers >= 2.2.1 is needed by package glibc-headers-2.5-123.el5_11.1.x86_64 (updates)

Error: Missing Dependency: kernel-headers >= 2.2.1 is needed by package glibc-headers-2.5-123.el5_11.1.x86_64 (updates)

Error: Missing Dependency: kernel-headers is needed by package glibc-headers-2.5-123.el5_11.1.x86_64 (updates)

You could try using –skip-broken to work around the problem

You could try running: package-cleanup –problems

package-cleanup –dupes

rpm -Va –nofiles –nodigest

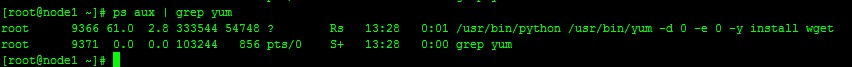

提示找不到 kernel-headers这个包,检查yum仓库没问题,后来确认是配置文件中禁止了 kernel-headers开头的包安装升级。

解决方法:

[root@1 ~]# vi /etc/yum.conf

bugtracker_url=http://bugs.centos.org/yum5bug

#exclude=kernel* cloud-init* qemu-ga* 添加#注释

PS: 这台机器为云服务器,基于openstack,估计是防止升级后出现异常,所以在系统中禁止了安装升级功能。